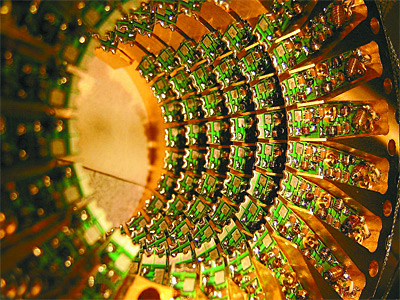

La computación cuántica amenaza con aumentar el potencial de cálculo de los ordenadores, que el proceso de descifrado por ensayo y error de los algoritmos actuales de encriptación, resultarían un juego de niños en comparación con el de la computación cuántica. Esta revolución se apoya en la mecánica cuántica, cuyo edificio teórico levantaron cuatro personalidades excepcionales: Niels Bohn, Max Planck, Werner Heisenberg y Erwin Schrödinger. La mecánica cuántica es una teoría de la física que sostiene que, en el ámbito macroscópico, rige las leyes de la física clásica, pero que, en el ámbito microscópico, rige la mecánica cuántica y sus paradojas.

Una de las aportaciones más brillantes a la mecánica cuántica es la de Erwin Schrödinger y su experimento del "gato de Schrödinger". La idea de este experimento era explicar el concepto de superposición de estados. El fenómeno de la superposición de estados sucede cuando una partícula ocupaba, a la vez, más de una posición, o poseía, al mismo tiempo, cantidades distintas de energía. Cuando se introducía un observador para medir alguna de estas variables, la partícula decidía adoptar una posición u otra o poseer una cantidad de energía u otra. Para explicar este fenómeno, Erwin Schrödinger ideó el famoso experimento del "gato de Schrödinger". ¿En qué consistió? "Imagínese un felino del tipo mencionado depositado en una caja sellada y opaca. En el interior de la caja se coloca un recipiente de gas venenoso conectado por un dispositivo a una partícula radiactiva de modo que, si ésta se desintegra, el gas escapa del recipiente y el gato muere envenenado. La partícula en cuestión tiene un 50% de probabilidades de desintegrarse durante un periodo de tiempo determinado." El tiempo se ha cumplido, la pregunta, que nos hacemos, es: ¿Está el gato vivo o muerto? En el lenguaje de la mecánica cuántica equivale a decir: ¿cuál es el estado del sistema caja- gato- mecanismo? Para conocer la respuesta es imprescindible que un observador abra la caja y "mida" el estado del sistema, entonces la partícula decidirá si se ha desintegrado o no, y, por tanto, el sistema "caja- gato- mecanismo" está en una superposición de estados: el gato no está ni vivo ni muerto, sino las dos cosas a la vez.

Ahora bien, si llevamos el concepto de superposición de estados a la computación o a la criptografía, ¿cuál sería la relación entre ambos? Hasta 1984, nadie se planteó esta posible relación. Fue el físico David Deutsch que empezó a barajar una idea revolucionaria: ¿cómo podría ser los ordenadores si obedecieran a las leyes de la mecánica cuántica? ¿De qué modo podría la computación cuántica sacar partido de la superposición de estados? A través de estas cuestiones, David Deutsch puedo iniciar sus investigaciones sobre la computación cuántica y puedo, posteriormente, a través de su trabajo probar que era posible teóricamente la construcción de un ordenador cuántico.

El desarrollo de una posible computación cuántica traería consigo el desmoronamiento de la criptografía moderna. Tomemos, por ejemplo, romper una clave RSA, ¿es posible? La respuesta es sí. Si se construyera un ordenador cuántico, y se ejecutará el algoritmo de Shor, la clave RSA se desmoronaría, y con él, el edificio de la criptografía moderna. Peter Shor en 1994 pudo demostrar que se puede romper una clave RSA a través de su algoritmo, que lleva su nombre, el algoritmo de Shor. Mediante este algoritmo pudo demostrar que, si se ejecuta este algoritmo en un ordenador cuántico, se podría descomponer números primos enormes en un tiempo menor que el del ordenador convencional más potente del mercado.

Otro aspecto de la mecánica cuántica es el principio de indeterminación de Weiner Heisenberg. Según el propio Heisenberg no podemos conocer con detalle el presente. Resulta imposible determinar ciertas propiedades de una partícula en un momento dado. Pongamos, un ejemplo, para ilustrar estas palabras: el caso de los fotones, y, muy concretamente, una de sus características más fundamentales: la polarización. Pues bien, el principio de Heisenberg afirma que la única manera de averiguar algo sobre la polarización de un foton es haciéndolo pasar por un filtro o "rendija". En función de, si el foton está polarizado, horizontalmente, verticalmente o diagonalmente, el resultado será distinto. En consecuencia, una vez emitido un foton no es posible saber con certeza cuál era la polarización original. Entonces, ¿qué relación existe entre la polarización de los fotones y la criptografía? En 1984, Charles Bennett y Gilles Brassard idearon un criptosistema cuántico basado en la transmisión de fotones polarizados. La información se transmitía por medio de fotones polarizados que es un canal seguro por medio del cual se puede transmitir una clave única. El resultado de este proceso de polarización, es que tanto el emisor como el receptor comparten una secuencia de unos y ceros generada de forma aleatoria. El criptosistema cuántico ideado por Brassard y Bennett impecable, desde el punto de vista teórico, se pudo llevar a la práctica en 1989, cuando se puso a punto un sistema criptográfico formado por dos ordenadores separados por una distancia de 32 centímetros, uno de los cuales iba a hacer las veces de emisor y, el otro, de receptor. Tras pruebas y ajustes, emisor y receptor pudieron verificar sus claves. La criptografía cuántica era posible. El criptosistema cuántico desarrollado por Brassard y Bennett representa el éxito del secreto sobre la indiscreción, de la criptografía frente al criptoanálisis.

Ahora bien, si llevamos el concepto de superposición de estados a la computación o a la criptografía, ¿cuál sería la relación entre ambos? Hasta 1984, nadie se planteó esta posible relación. Fue el físico David Deutsch que empezó a barajar una idea revolucionaria: ¿cómo podría ser los ordenadores si obedecieran a las leyes de la mecánica cuántica? ¿De qué modo podría la computación cuántica sacar partido de la superposición de estados? A través de estas cuestiones, David Deutsch puedo iniciar sus investigaciones sobre la computación cuántica y puedo, posteriormente, a través de su trabajo probar que era posible teóricamente la construcción de un ordenador cuántico.

El desarrollo de una posible computación cuántica traería consigo el desmoronamiento de la criptografía moderna. Tomemos, por ejemplo, romper una clave RSA, ¿es posible? La respuesta es sí. Si se construyera un ordenador cuántico, y se ejecutará el algoritmo de Shor, la clave RSA se desmoronaría, y con él, el edificio de la criptografía moderna. Peter Shor en 1994 pudo demostrar que se puede romper una clave RSA a través de su algoritmo, que lleva su nombre, el algoritmo de Shor. Mediante este algoritmo pudo demostrar que, si se ejecuta este algoritmo en un ordenador cuántico, se podría descomponer números primos enormes en un tiempo menor que el del ordenador convencional más potente del mercado.

Otro aspecto de la mecánica cuántica es el principio de indeterminación de Weiner Heisenberg. Según el propio Heisenberg no podemos conocer con detalle el presente. Resulta imposible determinar ciertas propiedades de una partícula en un momento dado. Pongamos, un ejemplo, para ilustrar estas palabras: el caso de los fotones, y, muy concretamente, una de sus características más fundamentales: la polarización. Pues bien, el principio de Heisenberg afirma que la única manera de averiguar algo sobre la polarización de un foton es haciéndolo pasar por un filtro o "rendija". En función de, si el foton está polarizado, horizontalmente, verticalmente o diagonalmente, el resultado será distinto. En consecuencia, una vez emitido un foton no es posible saber con certeza cuál era la polarización original. Entonces, ¿qué relación existe entre la polarización de los fotones y la criptografía? En 1984, Charles Bennett y Gilles Brassard idearon un criptosistema cuántico basado en la transmisión de fotones polarizados. La información se transmitía por medio de fotones polarizados que es un canal seguro por medio del cual se puede transmitir una clave única. El resultado de este proceso de polarización, es que tanto el emisor como el receptor comparten una secuencia de unos y ceros generada de forma aleatoria. El criptosistema cuántico ideado por Brassard y Bennett impecable, desde el punto de vista teórico, se pudo llevar a la práctica en 1989, cuando se puso a punto un sistema criptográfico formado por dos ordenadores separados por una distancia de 32 centímetros, uno de los cuales iba a hacer las veces de emisor y, el otro, de receptor. Tras pruebas y ajustes, emisor y receptor pudieron verificar sus claves. La criptografía cuántica era posible. El criptosistema cuántico desarrollado por Brassard y Bennett representa el éxito del secreto sobre la indiscreción, de la criptografía frente al criptoanálisis.